Bright Data

4.3

(855)

Bester für blockfreies Scraping

- Vorteile

- Nachteile

- Großer und effektiver Proxy-Pool

- Über 200 API-Call-Templates

- Option für Fully Managed Datasets

- Schneller und kompetenter Support

- Sehr teure Premium-Tarife

- Fehler bei Residential Proxies

| No-Code-Plattform | Nein |

|---|---|

| Proxies | < 72.000.000 |

| Einrichtung | 4 von 5 Sternen |

| Datenqualität | 4,5 von 5 Sternen |

| Export-Formate | Tabelle , API , JSON , BI-Tools , HTML , Webhook , Google Cloud , AWS S3 , Azure , Alibaba Cloud , Snowflake , weitere |

Bright Data landet in meinem Web Scraping-Test auf Platz 1. Das liegt vor allem an der großen Auswahl von Assistenztools wie der Captcha-Lösung und dem integrierten Parser, an den vielfältigen Datenformate und Export-Funktionen. Die Erfolgsquote von über 90 % ist hervorragend und der kompetente Support das i-Tüpfelchen.

Auch die Usability ist solide, erfordert aber Programmierkenntnisse, sonst bist du aufgeschmissen. Kannst du damit nichts anfangen, sind No-Code-Alternativen wie Octoparse, Parsehub oder WebScraper eher was für dich.

Besonders stark an Bright Data ist, dass du mit dem Scraping Tool überdurchschnittlich erfolgreich und mit wenigen Blocks sämtliche Arten von Daten crapen kannst. Dafür sorgt der große und zuverlässige Proxy-Pool, der Scraping ohne Blockierung ermöglicht. Captcha-Umgehung und Custom Header minimieren das Blockrisiko zusätzlich.

Heißt konkret: Es gibt fast nichts, was Bright Data nicht scrapen kann. Das klappt auch bei großen oder mehreren parallel laufenden Scraping-Jobs.

Bright Data ist im Kern eine Hilfestellung beim Bau von API-Calls mit Proxy-Unterstützung. Du nutzt dabei einen Code-Scraper, der folgende Code-Sprachen unterstützt:

- NodeJS (nativ)

- Python (nativ)

- Java (via Library)

- Ruby (via Library)

- C# (via Library)

- Go (via Library)

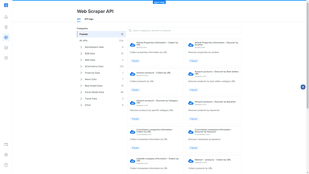

Bright Data kommt mit einer Auswahl an Templates, um deine Scraper-Einrichtung zu vereinfachen

Der Scraping-Erfolg ist überdurchschnittlich hoch. Nur in Ausnahmefällen stößt Bright Data an seine Grenzen. Probleme gibt es laut Community hin und wieder mit einzelnen Proxies im Bright Data-Netzwerk. Dann werden Scrape-Versuche trotz aller technischen Finessen geblockt.

Aber keine Panik: Es genügt eine Meldung an das Supportteam. Das findet fast immer einen Weg, nachzujustieren, und aktuelle Anti-Scraping oder Anti-Bot-Technologien auszuhebeln. Und ist dazu noch 24/7 und auf allen Kanälen erreichbar.

Ein weiterer Teil des Erfolgsrezeptes ist die Sammlung praktischer Templates für deine API-Calls. Damit baust du deine Scraper für die verschiedensten Anwendungsfälle schnellere und erfolgreicher zusammen:

"Bright Data ist eindeutig für Profis gemacht. Wer sich nicht auskennt, sollte ganz dringend die Finger davon lassen. Vor allem, weil nicht perfekt optimierte Runs mehr Credits kosten, als sie müssten. Hier empfiehlt sich definitiv Vorwissen! Profis bekommen dagegen einen gut gefüllten und verlässlichen Werkzeugkasten mit vielen tollen Features."

Content-Creator

Bright Data bedient sich eines Prepaid-Tarifs. Du zahlst jeden Monat ein Guthaben in Höhe des Monatspreises ein und nutzt dieses Guthaben zum Bezahlen deiner Scraping-Runs.

| Pay-as-you-go | $1/pro 1.000 Records |

|---|---|

| Growth | $499/Monat |

| Business | $999/Monat |

| Premium | $1.999/Monat |

| Enterprise | Auf Anfrage |

Das Tool ist nicht das günstigste auf dem Markt, trotzdem bewerte ich Bright Data in Sachen Kosten sehr positiv. Der Grund: es gibt eine Pay-as-You-go-Option, mit der eine smarte Kostenkontrolle möglich ist.

Mit diesem “Zahl-nur-was-du-brauchst”-Tarif eignet sich das “Luxus-Tool” Bright Data auch für Freelancer und Selbstständige. Eine Skalierung bis hin zu großen Unternehmen schafft der Scraper ebenfalls.